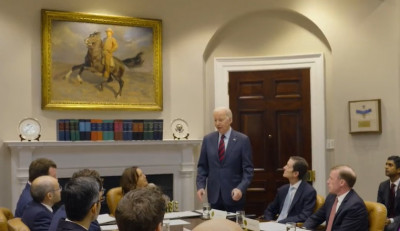

काठमाण्डौ । अमेरिकी राष्ट्रपति जो बाइडेनले बिहीबार माइक्रोसफ्ट र गुगललगायत शीर्ष आर्टिफिसियल इन्टेलिजेन्स कम्पनीका सीईओहरुलाई भेटेका छन्। बिडेनले कुनै पनि आर्टिफिसियल इन्टेलिजेन्स (एआई) प्रयोग गर्नुअघि तिनीहरु पूर्ण रुपमा सुरक्षित छन् वा छैनन् भन्नेबारे सुनिश्चिता गर्न निर्देशन दिएका छन्।

जेनेरेटिभ आर्टिफिसियल इन्टेलिजेन्स यो वर्ष धेरै चर्चा भएको छ। च्याटजीपीटीजस्ता एप यसमा अगाडि छन्। धेरै कम्पनीले यस्ता उत्पादन बनाइरहेका छन्।

राष्ट्रपति बिडेनले पनि च्याटजीपीटी प्रयोग गरेका छन्। उनलाई च्याटजीपीटीका बारे पनि जानकारी दिइएको थियो।

छलफलमा ओपनएआईका सीईओ साम अल्टम्यानले सबै कम्पनीहरुको नियमनमा एउटै किसिमको सोच रहेको बताए।

यो बैठक एआईको जोखिममा केन्द्रित थियो। यसमा गोपनीयताको उल्लंघन, रोजगारीमा भेदभाव, भ्रामक सूचनाजस्ता जोखिम समावेश थिए। बैठकले कम्पनीहरुको एआई प्रणालीका बारेमा नीति–निर्माताहरुसँग अझ पारदर्शी हुनुपर्ने आवश्यकतामा स्पष्ट र रचनात्मक छलफल भएको थियो।

दुई घन्टा चलेको छलफलमा गुगलका सुन्दर पिचाई, माइक्रोसफ्टका सत्य नडेला, ओपनएआईका साम अल्टम्यान र एन्थ्रोपिकका डारियो आमोदीका साथै उपाध्यक्ष कमला ह्यारिसको सहभागिता थियो। यीबाहेक बाइडेनका चीफ अफ स्टाफ र प्रशासनिक अधिकारीहरु पनि सहभागी थिए।

ह्यारिसले प्रविधिमा जीवन सुधार गर्ने क्षमता छ रहेको बताइन्। ‘तर, यसले सुरक्षा र गोपनीयता चिन्ताहरु पनि बढाउन सक्छ’, सीईओहरुलाई निर्देशन दिँदै उनले भनिन्, ‘एआई उत्पादनहरुको सुरक्षा सुनिश्चित गर्नु तपाइँहरुको कानुनी दायित्व हो।’ – एजेन्सी

2024-01-19

2024-01-19

2024-01-19

2024-01-19

2024-01-19

2024-01-19

2024-01-19

2024-01-19

2024-01-19

2024-01-19